Select the consents of your choice

10:40 min

10:40 min

Magdalena Drajkowska

04.08.2020

Magdalena Drajkowska

04.08.2020

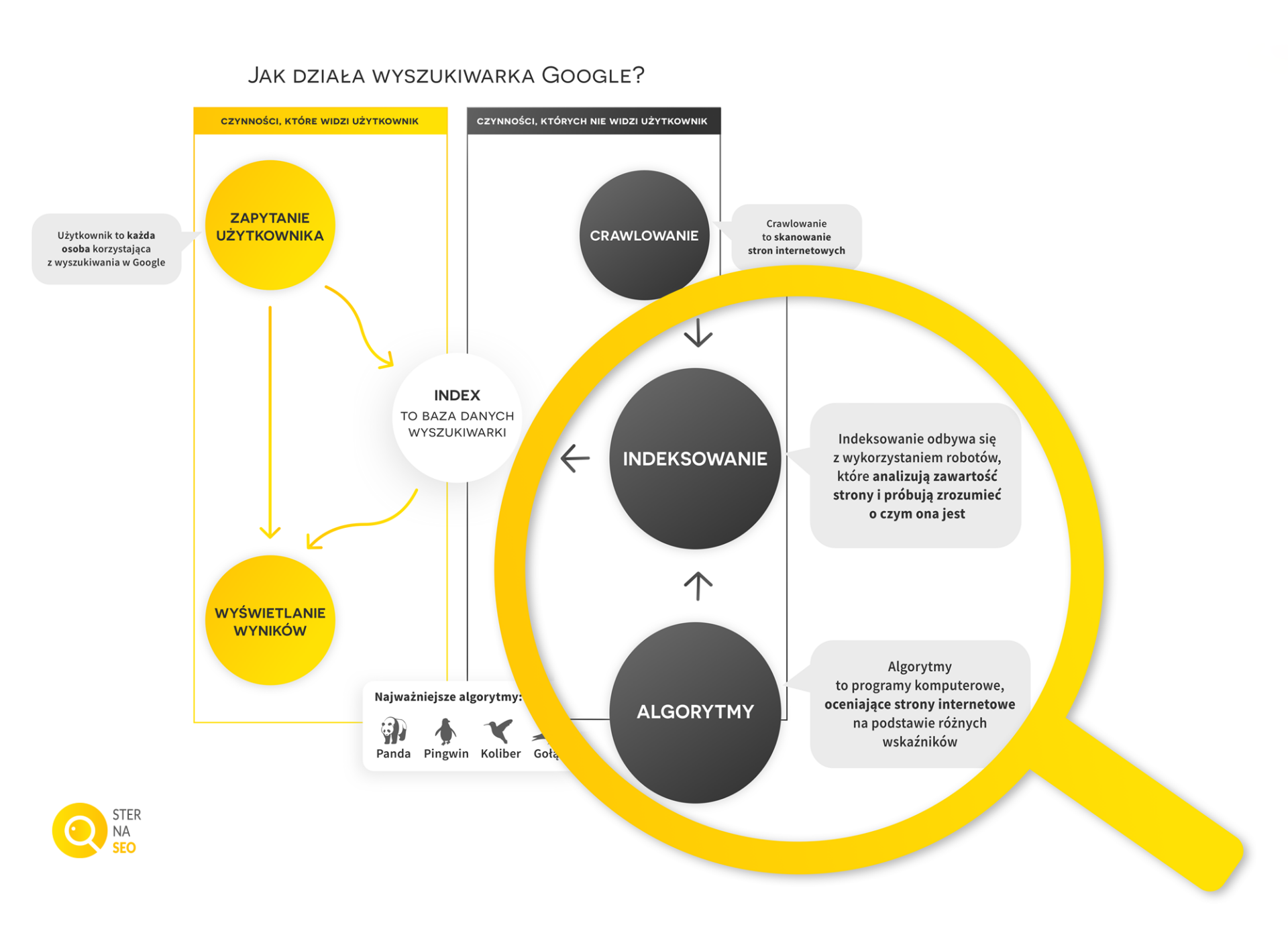

Wyszukiwarka Google dostarcza na zapytania użytkowników wyniki uszeregowane w określonej kolejności. Dzięki temu zamiast miliona stron luźno powiązanych z głównym tematem, otrzymujemy listę linków do witryn, na których z dużym prawdopodobieństwem znajdziemy interesujące nas informacje. Odpowiedzialne są za to tzw. algorytmy Google, czyli zaawansowane programy komputerowe, które oceniają strony internetowe na podstawie różnych czynników i ustalają ranking w naturalnych wynikach wyszukiwania. W ten sposób Google chce zapewnić nam jak najbardziej trafne i zróżnicowane wyniki, bowiem oprócz adresów stron www, prezentuje także inne elementy SERP.

Algorytmy Google wykorzystują setki, jeśli nie tysiące różnych czynników rankingujących (nie istnieje żaden spis ani wykaz z konkretną ich liczbą), które pozwalają ocenić przydatność stron i uszeregować je od najbardziej do najmniej trafnych. Mają za zadanie wydobyć z poszczególnych witryn informacje o największej dla użytkowników wartości. Swoją ocenę użyteczności opierają na takich danych jak np.

Systemy rankingujące Google stale ewoluują, aby możliwie jak najlepiej obsługiwać zapytania użytkowników, a tym samym zapewniać jak najlepsze wyniki wyszukiwania odbiorcom. Dlatego brane pod uwagę są coraz bardziej zaawansowane czynniki rankingujące, jak np. zauważenie kontekstu, poprawne wyświetlanie zawartości strony w różnych przeglądarkach i wiele innych.

Google, chcąc zapewnić jak najlepszą trafność wyników wyszukiwania, musi ciągle monitorować bezustannie zmieniające się środowisko Internetu. Każdego dnia w sieci pojawiają się nowe strony internetowe lub aktualizują się już istniejące. Aby w tych warunkach wyszukiwarka nadal wyświetlała wyniki odpowiadające jak najlepiej zapytaniom użytkowników, dochodzi do wielu zmian w algorytmach.

Częste aktualizacje mają więc na celu:

Docenienie w wynikach wyszukiwania tych witryn, które prowadzone są w sposób zgodny ze wskazówkami dla Webmasterów, np. umieszcza się na nich wartościowy content, skoncentrowany na użytkownikach.

Obniżenie w wynikach wyszukiwania witryn, stosujących praktyki, które próbują oszukać algorytmy Google i są niezgodne ze wskazówkami dla Webmasterów, np. nadużywają stosowania słów kluczowych, zamieszczają kopie tekstów, itp.

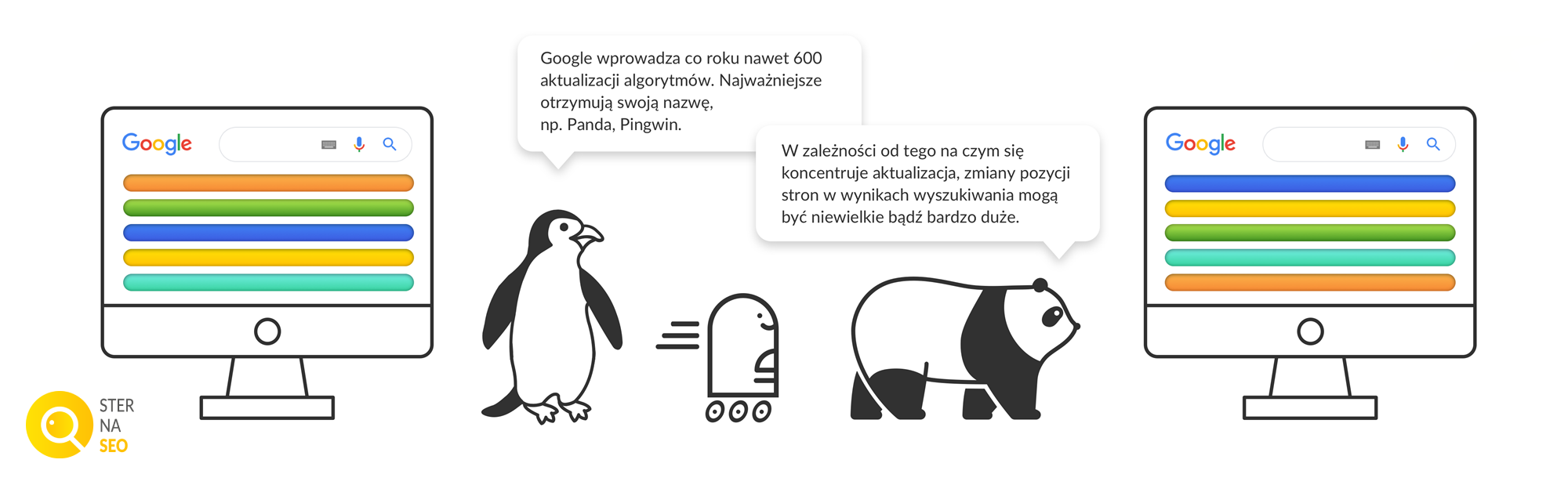

Ciekawostką jest, że przy udostępnianiu „dużych” aktualizacji algorytmicznych stosuje się bardzo często charakterystyczne nazwy, np. Panda, Pingwin, Koliber.

„Ściąga” z najważniejszych aktualizacji algorytmów

Historia aktualizacji algorytmów Google sięga końca lat 90-tych ubiegłego wieku. Składa się na nią szereg mniejszych oraz większych zmian. Do najważniejszych należy zaliczyć:

Listopad 2003 – Floryda, tę aktualizację uznaje się za rewolucyjną (dającą początek pozycjonowaniu), ponieważ jej implementacja przyczyniła się do spadku topowych pozycji wielu witryn, które stosowały niskiej jakości taktyki SEO (np. upychanie słów kluczowych).

Czerwiec 2010 – Kofeina, ta zmiana dotyczyła głównie infrastruktury, ale przełożyła się na przyspieszenie indeksowania i poszerzenie samego indeksu, a także umożliwiła zintegrowanie indeksowania oraz rankingowania praktycznie w czasie rzeczywistym.

Luty 2011 – Panda, ta aktualizacja algorytmu dotknęła przede wszystkim witryn ( wg Google nawet 12% wyników wyszukiwania!) o niskiej jakości zawartości, wysokim stosunku reklam do treści, itp.

Kwiecień 2012 – Pingwin, określany jako „aktualizacja dotycząca spamu w sieci”, która uderzyła w strony o niskiej jakości zapleczu linkowym i korzystające z tzw. Systemu Wymiany Linków.

Sierpień 2013 – Koliber, była to aktualizacja algorytmu, która miała na celu uzyskanie jeszcze trafniejszych wyników wyszukiwania dzięki rozpoznaniu synonimów, kontekstu haseł i sposobu interpretowania zapytania.

Lipiec 2014 – Gołąb, zmiany jakie wprowadziła ta aktualizacja miały jeszcze mocniej opierać się na czynnikach rankingowych, które Google stosował przy ogólnych wynikach wyszukiwania.

Październik 2015 – RankBrain jest rewolucyjną aktualizacją i stanowi jeden z najważniejszych czynników rankingowych, wpływając na pozycjonowanie stron internetowych. W najprostszym ujęciu jego zadaniem jest jeszcze lepsze dopasowanie wyników do zapytań użytkowników, również wprowadzanych językiem naturalnym.

Maj 2016 – Mobile friendly, aktualizacja algorytmu miała na celu wsparcie stron przyjaznych urządzeniom mobilnym.

Szczegółowe opisy poszczególnych aktualizacji algorytmów znajdziecie w odrębnych tekstach, ponieważ w tym artykule koncentrujemy się na zdefiniowaniu i wyjaśnieniu czym są algorytmy Google w ogóle.

Wiedząc już czym są algorytmy Google warto mieć na uwadze, że każdego roku może dojść do 500-600 (a nawet więcej!) zmian. Niekiedy są to drobne usprawnienia, których przeciętny użytkownik nie zauważa. Innym razem są to znaczące modyfikacje, oddziałujące na pozycjonowanie strony i ich miejsce w rankingach wyszukiwania. Aktualizacje algorytmów – w zależności od tego na jakim obszarze strony się koncentrują (content, profil linkowy, dopasowanie do urządzeń mobilnych, itp.) – mogą w mniejszym lub większym stopniu przyczyniać się do zmiany pozycji witryny w naturalnych wynikach wyszukiwania. To jaki jest wpływ algorytmów na pozycjonowanie wiąże się to z tym jak działa wyszukiwarka Google.

Google nie informuje jakie dokładnie powinno być nasycenie treści. Jednak firmy pozycjonujące strony internetowe oraz zajmujące się marketingiem w wyszukiwarkach internetowych na podstawie badań i testów przypuszczają, że istnieje bariera graniczna. Można przyjąć, że jest to ustalona, ale nieznana liczba pożądanych wystąpień wyrażeń kluczowych dla danej długości tekstu, którą algorytmy uznają za „wyczerpującą”. Należy mieć na uwadze, że równocześnie oceniają one daną treść także pod kątem innych czynników. Jeżeli ich suma będzie według algorytmów korzystna dla użytkownika, to nada takiej treści wyższy ranking w wynikach wyszukiwania

Nie warto jednak próbować oszukiwać poprzez stosowanie tzw. keyword stuffingu („upychanie” słów kluczowych). Występowanie fraz w zbyt dużej liczbie w tekście nie wpływa korzystnie ani w warstwie merytorycznej, ani pod kątem pozycjonowania stron.

W serii Ster na SEO poświęciliśmy cały artykuł wyjaśnieniu czym jest indeksowanie stron. Dla odświeżenia wiadomości przypominamy, że jest to jeden z procesów, który należy mieć na uwadze przy pozycjonowaniu witryn. Opiera się na gromadzeniu danych dotyczących treści, grafik, linków, słów kluczowych, stanowiących zawartość strony , a także na ich zachowaniu w bazie danych wyszukiwarki internetowej – czyli w indeksie.

Choć wiemy czym są algorytmy Google, nie posiadamy dokładnej wiedzy, jaki jest związek między ich działaniem a indeksowaniem. Gigant z Mountain View nie określił jednoznacznie i precyzyjnie tych relacji. Z dużym prawdopodobieństwem możemy jednak przypuszczać, że algorytmy – podobnie jak roboty indeksujące – działają ciągle, z tym że zamiast przeszukiwać nowe lub zaktualizowane strony internetowe, przeszukują istniejący indeks pod kątem konkretnych zapytań i niejako „z wyprzedzeniem” ustalają określoną hierarchię wyników, którą następnie wyświetlają, gdy rozpoznają pasujące do nich zapytanie w wyszukiwarce internetowej.

Gdyby nie algorytmy Google musielibyśmy samodzielnie „przekopywać” się przez góry niezadowalających nas rezultatów. Dzięki nim otrzymujemy gotową listę, dodatkowo zawierającą różne rodzaje elementów SERP, uszeregowaną w kolejności od potencjalnie najtrafniejszych do najmniej trafnych wyników.

Ocena związku z tematem (relevance) przez algorytmy Google jest uzależniona od kombinacji czynników off-page (poza stroną) i on-page (na stronie). Wspominaliśmy już, że w swojej pracy algorytmy Google wykorzystują czynniki rankingujące. Są one ze sobą w różny sposób powiązane. Zachodząca między czynnikami współpraca ma wpływ na ocenę trafności danej strony pod kątem zapytania użytkownika i związku z tematem, a co za tym idzie na pozycję witryny w naturalnych wynikach wyszukiwania. Takie zależności można zaobserwować niemal od początku działania wyszukiwarki Google.

Formuła PageRank (która od początku wyróżniała wyszukiwarkę Google od innych wyszukiwarek internetowych) opierała się na analizie liczby linków przychodzących do stron i ich jakości. Jeżeli więc na portalu popularnym i powszechnie cenionym znalazł się link do mniej znanej witryny, to w „oczach” Google stawała się ona bardziej wartościowa. Im więcej witryna zdobywała takich linków, tym wyżej w wynikach wyszukiwania się znajdowała. Obecnie formuła PageRank jest wykorzystywana, jednak nie publikuje się już jej wartości, co dawniej było praktykowane. Nie zmienia to faktu, że jej podstawowe założenie (czyli jakość ponad ilość) nadal stanowi ważny aspekt w branży SEO i SEM. Ponadto funkcjonowanie takiej współpracy można dostrzec również dziś między czynnikami rankingującymi, które decydują o trafności wyników wyszukiwania.

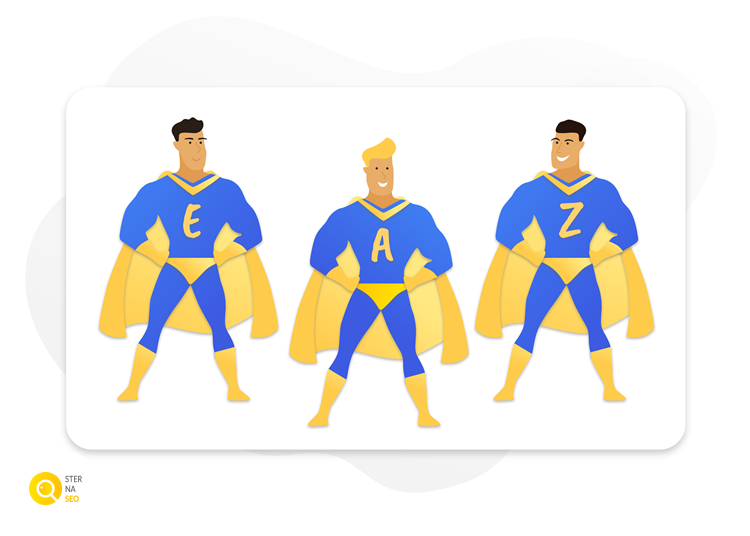

Wspomniana formuła PageRank bazowała na szczególnie pojętym autorytecie. Jeżeli potraktujemy każdy link, który prowadzi do naszej strony jako głos uznania, to im więcej takich głosów uzyska witryna tym lepiej. Ponadto, jeżeli taki głos pochodzi ze strony, która również ma dużo głosów, a więc cieszy się autorytetem, to nasza strona również zyskuje na znaczeniu, a więc jej autorytet się zwiększa. Jest to niezwykle istotne, ponieważ w lutym 2019 roku w dokumencie „How Google Fights Disinformation”. Google wskazał, jak ważnymi czynnikami rankingowymi są: eksperckość, autorytet i zaufanie, tzw. EAT (Expertise – Authoritativeness – Trustworthiness).

YMYL – żargon bez znaczenia?

Absolutnie nie! Pod skrótem YMYL („Your Money or Your Life”) kryje się określenie stron internetowych, które zawierają wrażliwe informacje, potencjalnie mające duży wpływ na życie użytkowników. Chodzi o strony finansowe, medyczne, prawne, jak również sklepy internetowe. Google bowiem stawia za cel swojej wyszukiwarce gwarantować nie tylko wyniki trafne pod kątem zapytań użytkowników, ale także pewne. Zawartość niektórych stron może bowiem w dużym stopniu wpływać na „szczęście, zdrowie lub bogactwo” użytkowników. Jeżeli takie strony byłyby niskiej jakości, to wpływ ten mógłby być negatywny. Dlatego Google szczególnie mocno analizuje strony z obszaru YMYL i nie chce sugerować wyników, które nie są eksperckie, godne zaufania i nie wzbudzają autorytetu.

Postawienie na te trzy cechy jako czynniki jest zrozumiałe, ponieważ użytkownicy oczekują, że znajdą w wynikach wyszukiwania rzetelne odpowiedzi. Jeżeli rezultaty ich rozczarują, to wpłynie negatywnie na ocenę przez nich samej wyszukiwarki. Właśnie dlatego algorytmy Google przy ocenie strony pod kątem trafności na zapytanie użytkownika zwracają uwagę na:

Eksperckość (Expertise) – a więc, czy zawartość strony przekazuje wiedzę oraz zawiera bieżące informacje na określony temat w danej branży. Lepiej mogą być oceniane te strony, które posiadają kilka kategorii w obrębie jednej dziedziny niż te zawierające kilka kategorii z zupełnie odmiennych zakresów tematycznych. Ponadto przy ocenie eksperckości strony może być brana pod uwagę branżowa terminologia.

Strona internetowa biura turystycznego będzie uchodziła za ekspercką, jeżeli znajdą się na niej zakładki z ofertami poszczególnych wycieczek, opisami kierunków, przydatnymi informacjami dla turystów (np. dotyczącymi wiz, szczepień, wymiany walut). Można wzbogacić ją też o artykuły zawierające porady dla podróżnych napisane z wykorzystaniem zwrotów branżowych – najlepiej z ich wyjaśnieniem (np. czym jest All Inclusive, BB, HB?)

Autorytet (Authoritativeness) – a więc, czy strona jest autorytetem w danej dziedzinie. Algorytmy Google mogą brać pod uwagę między innymi:

Stronę biura podróży można wzbogacić o np. artykuły podróżników, wywiady z podróżnikami lub blogerami podróżniczymi, wprowadzając ich zdjęcie i krótki biogram pod tekstem. Autorytet będą także budowały informacje o wygranych i wyróżnieniach biura podróży w plebiscytach oraz konkursach branżowych.

Zaufanie (Trustworthiness) – a więc, czy strona jest godna zaufania.

Strona biura podróży będzie budzić zaufanie, gdy użytkownik będzie mógł połączyć ją z adresem fizycznym zgodnym z tym, jaki wyświetla się na Mapach Google. Ponadto korzystnie na budowanie zaufania wpływają opinie Klientów i recenzje wczasowiczów, którzy korzystali z usług takiego biura i dzielą się opinią na stronie www.

Prowadzenie strony internetowej zgodnie z założeniami E-A-T sprawia, że algorytmy Google mogą ocenić taką witrynę jako dostarczającą trafniejszych odpowiedzi użytkownikom. Dzięki temu zaprezentują ją odbiorcom wyżej w naturalnych wynikach wyszukiwania, co korzystnie wpływa na pozycjonowanie. Stosowanie się do zasad EAT jest w rzeczywistości zbieżne z naturalnymi odruchami twórców treści internetowych, którym zależy na dotarciu do jak największego grona odbiorców. Pragnąc osiągnąć ten efekt muszą odpowiadać na potrzeby użytkowników, którzy będą chcieli zaufać, będą oczekiwali eksperckich treści i będą gotowi uwierzyć, ale tylko autorytetowi

Algorytmy Google a machine learning

Czy wiesz, że algorytm Google nie tylko ocenia stronę pod kątem zgodności z zapytaniem użytkownika, ale jednocześnie „uczy się”? RankBrain, którego znaczenie w świecie algorytmów Google rośnie, wykorzystuje uczenie maszynowe, aby ustalić najtrafniejsze wyniki dla zapytań wprowadzanych do wyszukiwarki. Podobnie jak algorytm Koliber stara się zrozumieć zamiar użytkownika, jednak RankBrain skupia się na nowo pojawiających się w wyszukiwarce zapytaniach.

Aby zrozumieć czym jest algorytm Google po wprowadzeniu RankBrain należy mieć na uwadze, że jego celem jest jeszcze lepsze zaspokojenie potrzeb użytkowników, dlatego:

Jednoznaczne zdefiniowanie czym są algorytmy Google może być z jednej strony bardzo proste. Są to bowiem zaawansowane programy komputerowe. Ich celem jest ocena stron internetowych pod kątem trafności odpowiedzi na zapytanie użytkownika. Z drugiej jednak strony to czym są algorytmy Google definiuje sposób ich działania, a ten nie jest jasno i przejrzyście wyjaśniony przez Google. Wobec czego osoby z branży SEM i SEO muszą w wielu aspektach bazować na wnioskach pochodzących z samodzielnie przeprowadzanych testów.

Ponadto sam Google przyznaje, że w ciągu roku może dojść do kilkuset aktualizacji algorytmów, które będą kładły nacisk na odmienne czynniki rankingowe wspierające ocenę stron internetowych. Gdy na to nałożymy jeszcze brak konkretnych informacji ze strony Google o sposobie oddziaływania na siebie poszczególnych czynników rankingowych, to dostrzeżemy jak prosta definicja bardzo się komplikuje. Jednak możemy być pewni, że:

Google nie zawsze informuje o planowanych zmianach algorytmów, jednak śledzenie doniesień o nich powinno być istotnym elementem strategii marketingowej każdego właściciela strony internetowej. Jednak Ci, którzy stosują się do wytycznych dla Webmasterów oraz praktyk White Hat SEO mogą raczej spać spokojnie, ponieważ ich witryny są odporniejsze nawet na duże wstrząsy algorytmiczne.

Źródła: Google, Webfx, Search Engine Land, Copypress, Wordtracker, Webmasters Google, Moz

Sprawdź w 90 sekund, jak Twoja strona radzi sobie w sieci!

Pod lupę bierzemy aż 70 różnych parametrów.

Odbieraj regularną dawkę wiedzy i nowości ze świata digital marketingu!

Zero spamu, tylko konkrety!

8:40 min

27.08.2020

Nie każda aktualizacja algorytmu Google jest przez firmę ogłaszana i komentowana. Mimo tego społeczność zawsze trzyma rękę na pulsie i stara się wysnuć teorie, które maja na celu wyjaśnienie wpływu update'ów na wyszukiwarkę. Czemu warto się z nimi zapoznać? Stanowią bardzo ważną informację jeśli chodzi o kierunek rozwoju wyszukiwarki oraz zmian w SERP.

8:40 min

27.08.2020

Nie każda aktualizacja algorytmu Google jest przez firmę ogłaszana i komentowana. Mimo tego społeczność zawsze trzyma rękę na pulsie i stara się wysnuć teorie, które maja na celu wyjaśnienie wpływu update'ów na wyszukiwarkę. Czemu warto się z nimi zapoznać? Stanowią bardzo ważną informację jeśli chodzi o kierunek rozwoju wyszukiwarki oraz zmian w SERP.

6:10 min

03.09.2020

Zmienność środowiska Google motywuje nas do poszukiwania nowych rozwiązań, dzięki którym niespodziewana aktualizacja algorytmów nie zniweczy efektów wielu miesięcy, a nawet lat ciężkiej pracy. Takim rozwiązaniem jest budowanie widoczności strony na wiele fraz zbudowanych z kilku wyrazów. W świecie SEO strategię tę określamy jako pozycjonowanie long tail. Skąd pochodzi ta koncepcja i dlaczego warto o niej pamiętać?

6:10 min

03.09.2020

Zmienność środowiska Google motywuje nas do poszukiwania nowych rozwiązań, dzięki którym niespodziewana aktualizacja algorytmów nie zniweczy efektów wielu miesięcy, a nawet lat ciężkiej pracy. Takim rozwiązaniem jest budowanie widoczności strony na wiele fraz zbudowanych z kilku wyrazów. W świecie SEO strategię tę określamy jako pozycjonowanie long tail. Skąd pochodzi ta koncepcja i dlaczego warto o niej pamiętać?

11:20 min

23.07.2020

W praktyce keyword research składa się z dwóch elementów: gromadzenia oraz sprawdzania słów kluczowych. Jeśli zastanawiasz się czym tak właściwie jest i jak dokładnie go przeprowadzić, to świetnie się składa! W dzisiejszym artykule wyjaśniamy, jak powinien wyglądać każdy z tych etapów oraz co zrobić, by znaleźć najlepsze frazy. Jeśli jesteś ciekaw zapraszamy do lektury!

11:20 min

23.07.2020

W praktyce keyword research składa się z dwóch elementów: gromadzenia oraz sprawdzania słów kluczowych. Jeśli zastanawiasz się czym tak właściwie jest i jak dokładnie go przeprowadzić, to świetnie się składa! W dzisiejszym artykule wyjaśniamy, jak powinien wyglądać każdy z tych etapów oraz co zrobić, by znaleźć najlepsze frazy. Jeśli jesteś ciekaw zapraszamy do lektury!

20:00 min

28.09.2023

Optymalizacja strony pod kątem SEO to proces długofalowy. Wymaga umieszczenia każdej nowej treści w odpowiednim miejscu struktury. Jak wesprzeć proces pozycjonowania?

20:00 min

28.09.2023

Optymalizacja strony pod kątem SEO to proces długofalowy. Wymaga umieszczenia każdej nowej treści w odpowiednim miejscu struktury. Jak wesprzeć proces pozycjonowania?

Na dobry start

proponujemy Ci bezpłatnie: